使用 ONNX 运行时本机库从 BP 和 C++ 轻松、加速的 ML 推理。

只需调用几个蓝图节点,即可加载和运行尖端 AI。

该插件支持 ONNX(开放神经网络交换),这是一种广泛使用的开源机器学习模型格式。

PyTorch 和 TensorFlow 等许多 ML 框架都可以将其模型导出为 ONNX 格式。

ONNX Model Zoo上提供了许多经过训练的模型。

性能是我们首先考虑的。

此插件支持运行时模型优化和各种硬件上的 GPU 加速,并且此插件本身已优化。

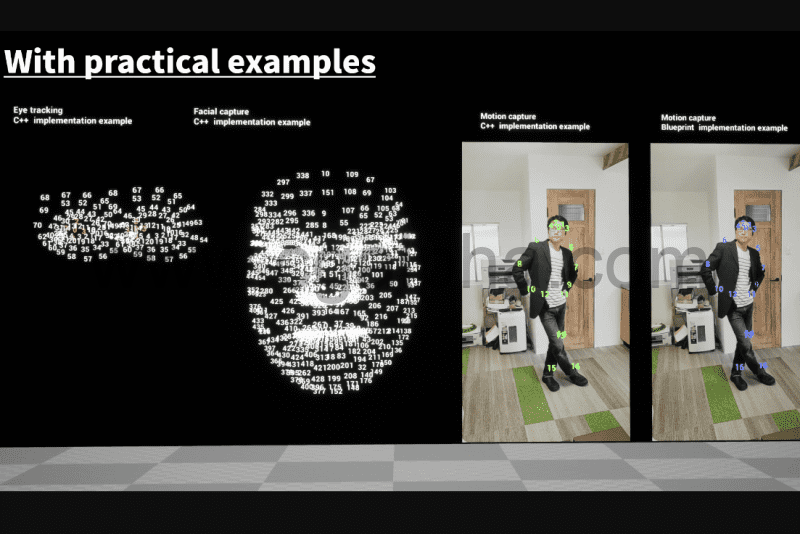

- 人体检测

- 人体姿态估计

- 人脸检测

- 面部标志估计

- 眼动追踪

使用 CUDA 和 TensorRT 的先决条件

要与 CUDA 和 TensorRT 一起使用,您需要安装以下版本的 CUDA、cuDNN 和 TensorRT。

视窗:

RTX30** 系列和其他系列的 cuDNN 和 TensorRT 版本不同。我们只测试了 GTX1080Ti、RTX2070、RTX3060Ti 和 RTX3070。其他的没有测试。

RTX30** 系列以外的版本(RTX20**、GTX10**)

- CUDA:11.0.3

- cuDNN:8.0.2(2020 年 7 月 24 日),用于 CUDA 11.0

- TensorRT:7.1.3.4 用于 CUDA 11.0

RTX30** 系列的版本

- CUDA:11.0.3

- cuDNN:8.0.5(2020 年 11 月 9 日),用于 CUDA 11.0

- TensorRT:7.2.2.3 用于 CUDA 11.0

Ubuntu:

- CUDA:11.4.2 适用于 Linux x86_64 Ubuntu 18.04

- cuDNN:8.2.4(2021 年 9 月 2 日),适用于 CUDA 11.4,Linux x86_64

- TensorRT:适用于 Linux x86_64、CUDA 11.0-11.5 的 8.2.3.0(8.2 GA 更新 2)

要与 TensorRT 一起使用,建议将以下环境变量添加到缓存 TensorRT 引擎:

- “ORT_TENSORRT_ENGINE_CACHE_ENABLE”并将其值设置为“1”。

- “ORT_TENSORRT_CACHE_PATH”并将其值设置为您要保存缓存的任何路径,例如“C:\temp”。

wb:https://www.unrealengine.com/marketplace/en-US/product/NNEngine-neural-network-engine?sessionInvalidated=true

1、本站资源大多来自网友发稿,如有侵犯你的权益请联系管理员,我们会第一时间进行审核删除。仅用于个人学习或测试研究使用,Email:730033856@qq.com

2、有很多小伙伴经常问插件无法安装,有很大一部分用英文原版就可以解决问题。以便于在未来的学习和工作可以更高效的吸收英文资源,提高大家的学习效率和学习效果。

3、交流反馈插件素材更多问题~可以联系加QQ群:819091096

解压密码点击查看